ローカル環境でAIを利用するための様々なツールが開発されていますが、現状Windowsで一番簡単に使えるのが、LM Studioです。クラウドベースのAIを利用すると、個人情報や機密情報が特定の企業に漏洩するということになりますし、政治的な思惑に巻き込まれる可能性もあります。ローカルでLM Studioを利用すればすれば、プライバシーを守りながら、自由にAIを使うことができます。この記事では、LM Studioを使うために必要となるAI用語と、おすすめのモデルについて解説しています。

LM Studioの概要とAI基本用語

LM Studioについてのよくある質問と、最低限必要となる用語について解説しています。

LM Studioとは

LM Studioとは、ローカル環境で大規模言語モデル(LLM)を実行できるプラットフォームです。

Windows、macOS、Linuxで利用できます。

インストールが簡単で、Hugging Faceで公開されているAIモデルをアプリ内からダウンロードできることが特徴です。

また、OpenAI互換のAPIサーバーとして起動し、他のアプリと連携させることもできます。

Ollamaとの違い

同じくローカル環境でLLMを管理できるプラットフォームとしてOllamaがあります。

-

中国のAI「DeepSeek-R1」をOllamaを使ってWindowsローカルで動かす方法

中国企業が開発した生成AIモデル「DeepSeek-R1」が話題となっており、アプリストアでもランキングを伸ばしていますが、プライバシー保護の観点から利用することは待ったほうが良いです。この記事では、 ...

LM Studioは、GUIによって直感的な操作ができます。

Ollamaは、CUIによるコマンド操作が基本です。

LM Studioは、Hugging Faceで公開されている多様なモデルを簡単に導入できます。

Ollamaは、主要なオープンソースのモデルに対応しています。

初心者にはLM Studioの方が簡単に使えますが、複雑なことをしようとすると、どちらもプログラミング等の知識が必要となるところは同じです。

現在、ローカルAIのニーズが高まっており、LM StudioやOllama以外にも様々なツールが開発されていますので、将来的にもっとよいものが出てくるかもしれません。

商用利用できる?

LM Studioは個人においては無料で使用できますが、商用利用は禁止されています。

必要な場合は開発会社のElement Labs社に連絡をしてください。

画像認識・画像生成できる?

使用するモデルによっては、画像認識をすることができます。

画像生成には、対応していません。

できないことはないのでしょうが、画像に特化したStable Diffusionなどを使用した方がはるかに簡単です。

-

画像生成AI Stable Diffusionのローカル環境を簡単に構築できるEasy Diffusionの使い方

2025/3/7 Stable Diffusion, 画像生成

画像生成AIに興味があるけど、何から初めていいのか分からないという方には、Easy Diffusionをおすすめします。Easy Diffusionを使えば、インストーラーで数回クリックするだけで、ロ ...

日本語に対応している?

LM Studioは、設定でUIを日本語表記にすることはできますが、翻訳される箇所が少なくほぼ意味はありません。

また下記でご紹介するように、AIには専門用語が多いので、英語で使用することに慣れたほうがよいと思います。

AIと日本語でやり取りできるかというのは、使用するモデルによります。

知っておきたい用語

LM Studioの使い方は簡単ですが、AI界隈で使われている用語を知っておかないと、どのモデルを選んで良いのか分からないということになります。

ここでは、よく使われる用語について簡単に解説をします。

LLM

「LLM(Large Language Model、大規模言語モデル)」とは、学習されたAIデータ一式のことです。

目的や使用環境に合わせて、様々なモデルが開発されています。

LLaMA

「LLaMA(Large Language Model Meta AI)」とは、Meta社が開発したLLMの一つです。

LLMと名前が似ているので混同しがちですが、まったく異なります。

GGUF/GGML

「GGUF(General Graph Unified Format)」とは、LLMのファイル形式の一つです。

軽量なため、ローカル環境での実行に適しています。

LM Studioの標準フォーマットとなっています。

GGUFに対し、従来のフォーマットは「GGML(General Graph Machine Learning)」と呼ばれています。

Quantization

「Quantization(量子化)」は、AIモデルを軽量化、高速化するための手法です。

通常AIモデルは32ビットの浮動小数点で計算されますが、これを16ビットや8ビットに変換することで、サイズが大幅に縮小され、計算も高速化されます。

もちろん精度は低下しますが、それ以上のメリットがあります。

「Q8_0」「Q3_K_5」などで表記され、Qの後ろの数字がビット数です。

数字が小さいほど軽量で高速ということになります。

「K(K-means clustering、分割して部分的に量子化)」「M(Mixed Precision、異なる精度を混合)」などのオプションが付くこともあります。

Distillation

「Distillation(蒸留)」も、AIモデルを軽量化、高速化するための手法です。

Quantizationとの違いは、Quantizationがモデルを変換しているだけなのに対し、Distillationは元となる「教師モデル」を使って「生徒モデル」に学習させているという点です。

これにより、精度を維持しつつ、小さなモデルを再構築しています。

Distillationの方が手間がかかります。

Fine Tuning

「Fine Tuning(ファインチューニング、微調整)」とは、特定の用途に合わせてモデルに追加学習を行うことです。

QuantizationやDistillationなどの軽量化とは異なり、追加という点が重要です。

日本語に対応させることもファインチューニングと呼ばれます。

Architecture

「Architecture(構造)」は一般的な用語ですが、AIモデルに対して使われる場合は、ファミリーやグループといった意味です。

- GPT:OpenAI

- LLaMA:Meta

- Qwen:Alibaba

- Mistral:Mistral

- Claude:Anthropic

- Gemma:Google

等が有名です。

Params

「Params(パラメーター数)」は、AIモデルの大きさを表す指標です。

「B(ビリオン、10億)」が基本単位で、だいたい以下のように分類されます。

- 小規模:7B以下

- 中規模:7~13B

- 大規模:30B以上

ローカルで実行する場合は、中規模モデルが基本となるでしょう。

RAG

「RAG(Retrieval Augmented Generation)」は、LLMが外部の情報を参照し、それを基に回答を生成する技術です。

LLMは、事前に学習されたデータに基づいて回答するのが基本です。

RAGによって、外部のデータベースを活用したり、インターネット上から最新情報を取得したりすることが可能となります。

Hugging Face

「Hugging Face」は、AIに関してののオープンソースプラットフォームです。

様々なモデルが公開されていたり、クラウド上でデモを実行できたりします。

LM Studioの使い方とおすすめモデル

LM Studioのインストール方法と、日本語に対応したモデルの回答例をご紹介しています。

インストール

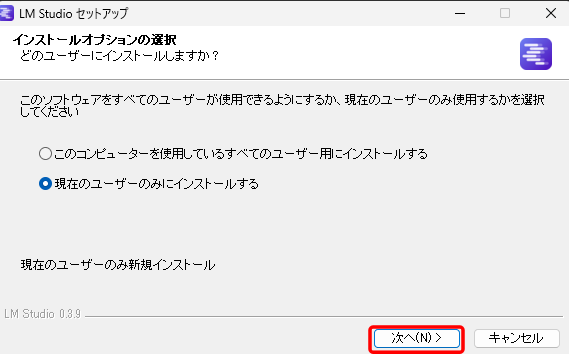

Windows PCにLM Studioをインストールする方法をご紹介します。

ブラウザで「https://lmstudio.ai/」を開き、「Download LM Studio for Windows」をクリックします。

ダウンロードしたインストーラーを実行します。

あとは、「次へ」を数回クリックすればインストールが完了します。

完了しました。

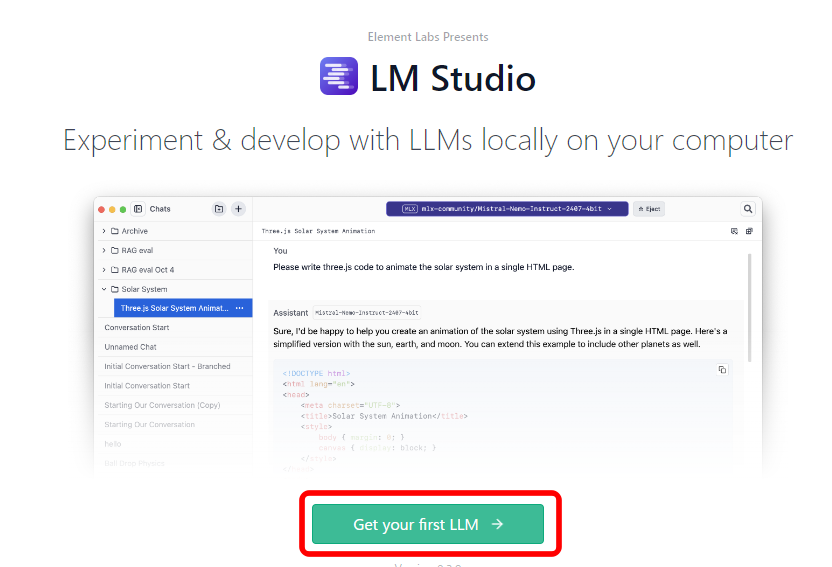

起動すると、最初にAIモデルのダウンロード画面となります。

「Get your first LLM」をクリックします。

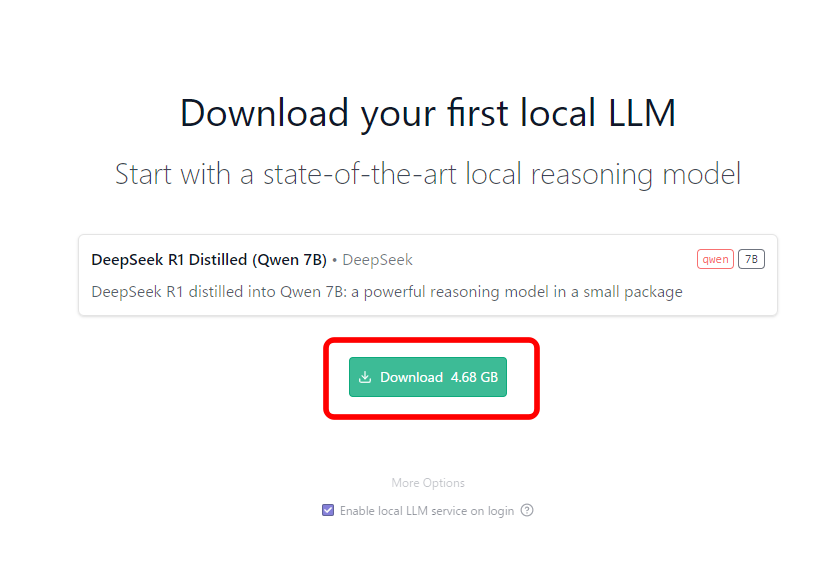

PCスペックに合わせた最適なモデルが選択されるようです。

「Download」をクリックします。

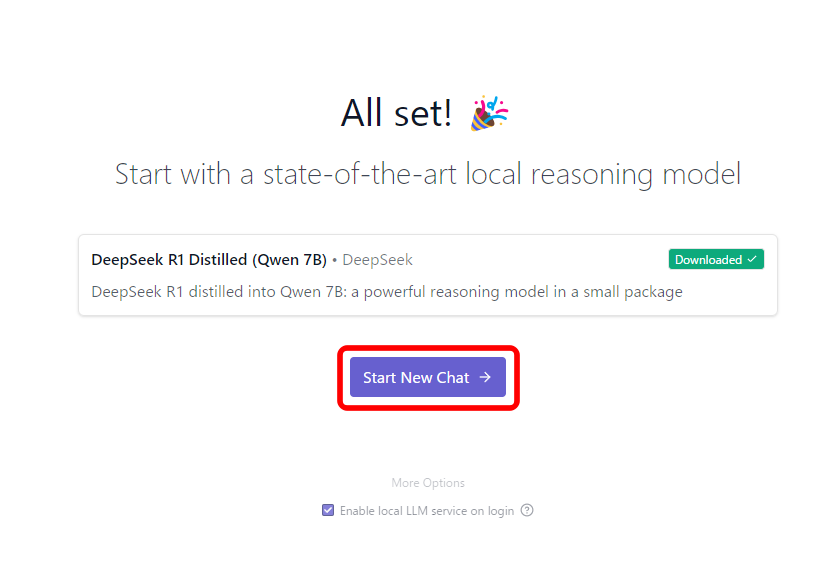

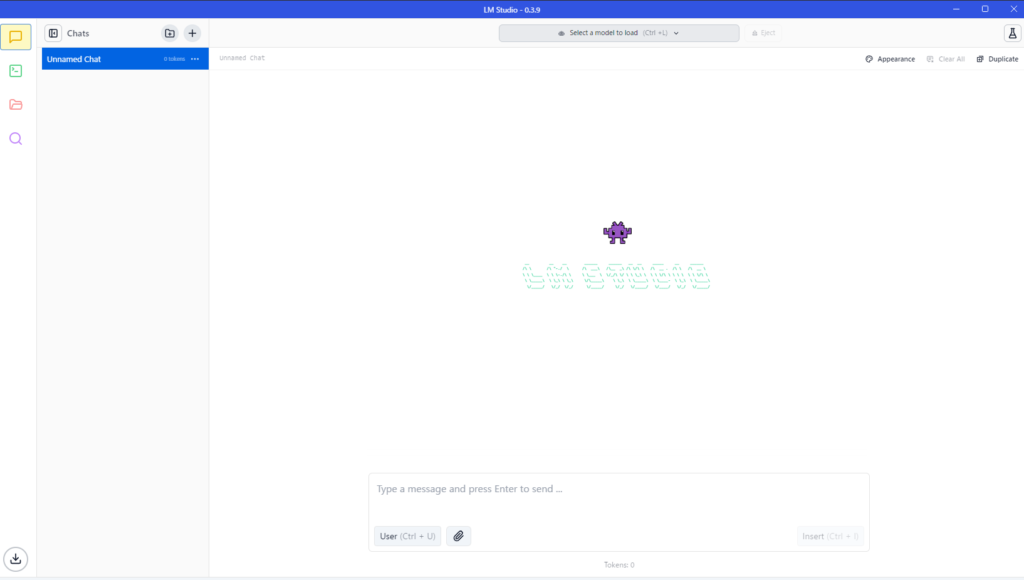

「Start New Chat」をクリックします。

使用できる状態となりました。

使い方は、ChatGPT等に慣れている方であれば、見れば分かると思います。

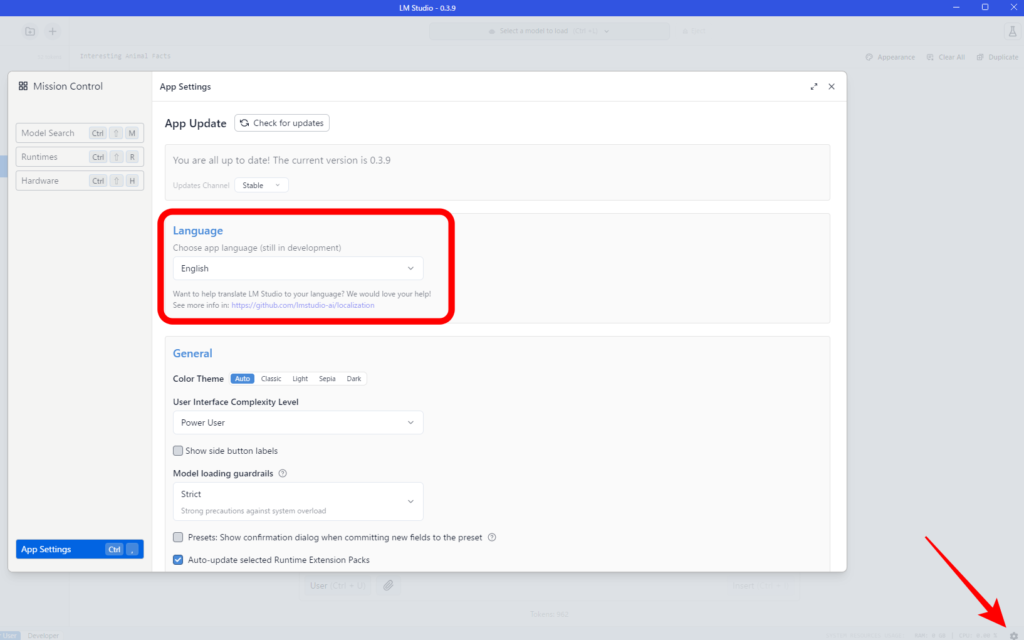

日本語化

UIを日本語にするには、右下の歯車アイコンをクリックし、「Language」から選択します。

ただ、UIが優れているので、特に変更する必要もないと思います。

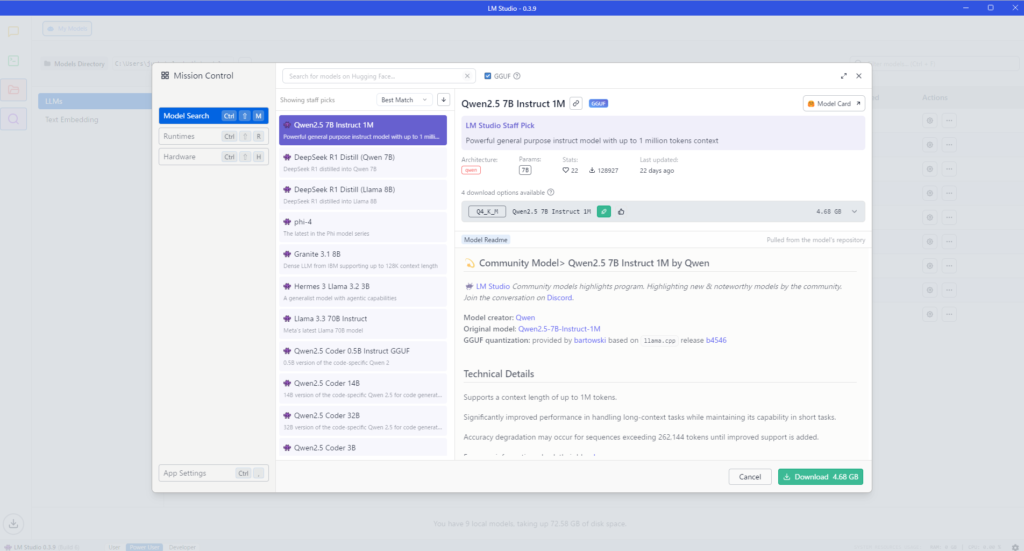

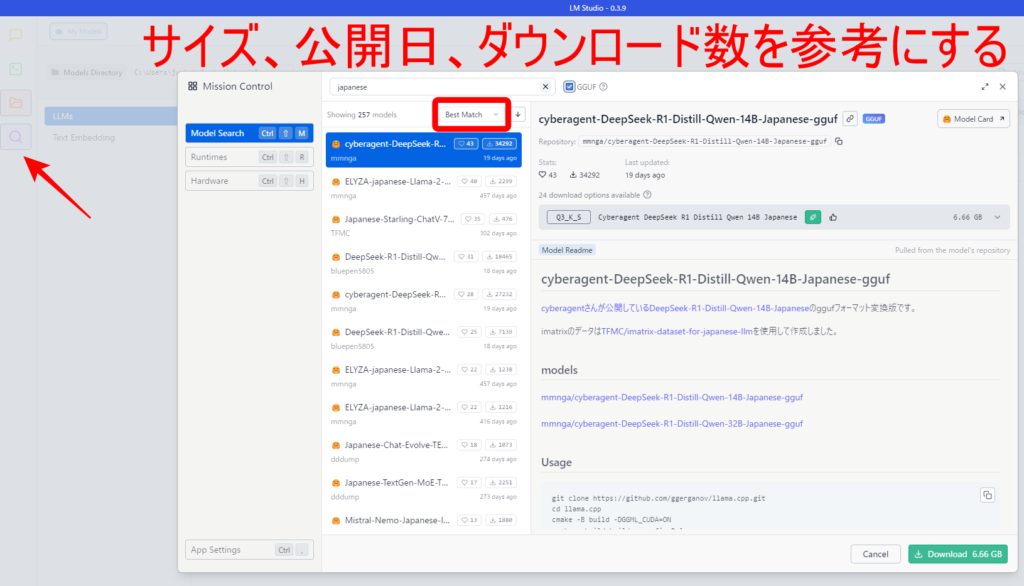

モデルのダウンロード

モデルを追加でダウンロードするには、左の虫眼鏡アイコンをクリックします。

LM Studioの便利なところは、PCスペックに合わせたモデルを自動的に選んでくれるという点です。

AIの進歩は速いので、なるべく最新のもので、サイズや人気のバランスを見ながら選択するとよいでしょう。

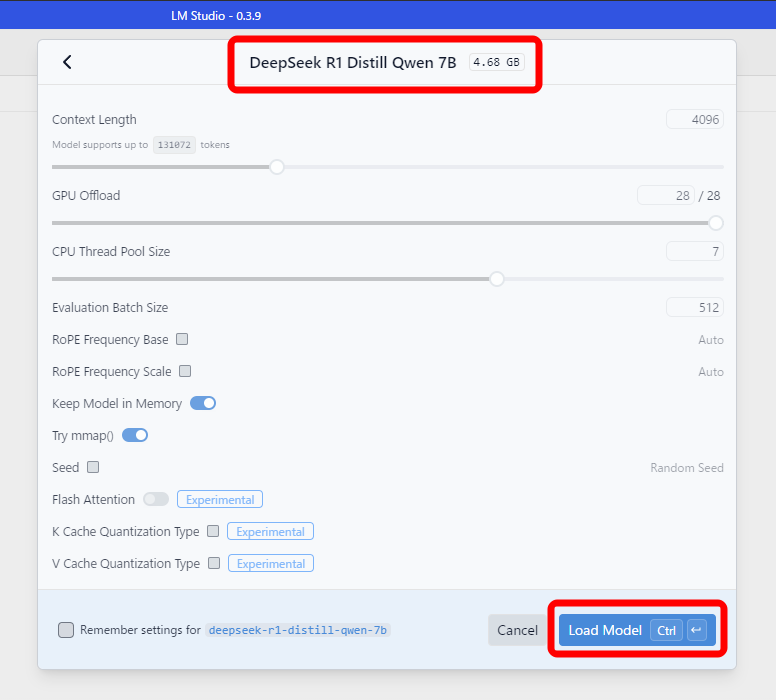

ダウンロードしたモデルは、チャット画面の上部から選択してロードします。

いろいろとパラメーター変更ができますが、とりあえずは初期設定のままでいいと思います。

日本語に対応したおすすめモデル

LLMには得手不得手がありますので、何がおすすめかというのは、使用目的とPCスペックによります。

ここでは、日本語でチャットができるという観点で、いくつか選んでみました。

「面白いこと言って」という質問に対する回答を、モデル別にご紹介します。

deepseek-r1-distill-qwen-7b(4.68GB)

Hey! Here's something interesting: The ocean covers about 71% of the Earth's surface, but only a small part of it is drinkable. Most of the ocean water is too salty to drink, except for the tiny parts that make up our saltwater lakes and rivers.

Also, did you know that octopuses have three hearts? Two pump blood towards the head, and one pumps it towards the tail! 🐙

And speaking of animals, I just learned that sloths can hold their breath longer than dolphins—like 10-15 minutes versus a few minutes! 😺

How about some fun facts or would you like me to tell you something specific? Let me know!初回起動でダウンロードされた、DeepSeek-R1の蒸留モデルです。

日本語で質問しましたが、英語で回答されました。

しかし、内容としては悪くないと思います。

これが、DeepSeekが世間を騒がせている所以です。

rakutenai-7b-chat(4.20GB)

私はAI言語モデルであるため、面白いことを言う機能は備わっていないかもしれません。申し訳ありません。

何か他に助けを求めていることはありますか?楽天が公開しているモデルです。

そっけないですが、ある意味正解かもしれません。

llama-3-elyza-jp-8b(4.92GB)

「人生は、ピザに似ている。トッピングを間違えれば、後悔するが、美味しくなる可能性もある。」

どうでしょうか?Elyza社のモデルを日本語強化したものです。

面白くはないですが、自然な会話となっています。

gemma-2-9b-it(5.76GB)

どうしてバナナは黄色くなるのか?

答え: なぜなら、緑色が飽きたから!🍌😜

もっと面白おかしく何か聞きたいですか?😊Googleが開発したモデルです。

ユーモアのセンスがありますね。

mistral-nemo-japanese-instruct-2408(7.07GB)

もちろんです!ここに一つ、面白いことをお届けします。

ある日、動物たちは森の中で「誰が一番賢いか」というコンテストを開催しました。ウサギは足の速さを自慢し、キリンは首を高く伸ばして見下ろしていました。しかし、小さなハリネズミが言いました。「みんなの特技は素晴らしいけど、ぼくは特別な力を持っているんだ。」

興味を引かれた動物たちは、ハリネズミにどんな力があるのかと尋ねました。するとハリネズミは、「ぼくには、誰も解けない難題を作る力があるんだよ。」と言いました。

そこで動物たちは試してみることにしました。「じゃあ、このコンテストの勝者を決める最も難しい質問を出して!」と頼みました。ハリネズミは少し考えて、「こんな質問はいかが?」と言いながら問いかけました。「もし全ての動物が一斉に走り出した瞬間、同時にどこに到達するのか?」

一瞬、森中が静まり返りました。誰もその質問に答えることができませんでした。

結局、ハリネズミは笑って言いました。「答えは簡単さ。みんなのスタート地点から一緒に走るんだもの、全ての動物は同時に自分たちの場所に到達するよ。」

動物たちは顔を見合わせて大笑いしました。そして、ハリネズミが持っているユーモアと知恵を評価し、この小さなハリネズミが「賢さ」の新しい基準を作り出したことを祝福しました。

それ以来、森では誰も自分たちの特技に固執せず、お互いの違いやユーモアを楽しむようになったそうです。😊

どうでしたか? 楽しんでいただけたら幸いです!NVIDIAとMistral AIが開発したモデルを、CyberAgentが日本語チューニングしたものです。

面白くはないですが、かなりの長文となっています。

cyberagent-deepseek-r1-distill-qwen-32b-japanese(14.39GB)

DeepSyeek-R1の蒸留モデルを、CyberAgentが日本語チューニングしたものです。

<think>

まず、ユーザーが「面白いこと言って」と日本語でリクエストしているので、最初にそのリクエストを正確に理解する必要があります。日本語の返信を求めているため、適切なユーモアや面白さのある回答を考える必要があります。

次に、どのような内容が面白く、かつユーザーにとって受け入れやすいかを検討します。例えば、ダジャレや言葉遊び、意外性のある結末などが考えられます。また、ユーザーの興味に関連する要素を取り入れることで、より親しみやすい回答になる可能性があります。

さらに、適切なバランスを見極めることが重要です。過激すぎず、かつ笑いを誘うような内容にする必要があります。例えば、日常的な状況をユーモラスに変えてみたり、逆説的な発想を使う方法が有効かもしれません。

具体的には、「もしも地球がクレヨンの箱みたいだったら…」といった想像力豊かな例や、動物たちが人間のように行動するシナリオなどが考えられます。また、言葉遊びとしては「りんごとバナナを合わせると『りんぱな』になる」といったダジャレも有効です。

最後に、ユーザーとの会話の流れを考慮し、自然で柔らかいトーンを保つように心がけます。これにより、親しみやすく、笑いを誘う回答を提供できるでしょう。

</think>DeepSeekの特徴は、AIの思考過程も表示されるということです。

ここでは、「面白い」という概念を理解していることが分かります。

**面白いことと言えば……**

もし「猫」が人間と話し合えたなら、彼らはきっとこう言いそうです:

「お前らの家に侵入し続ける理由は、『毛布カバー』と『飼い主不在の時間』の組み合わせが完璧だからだ。科学的根拠あり。」

---

**なぜ猫?**

理由は単純──「彼らは既に宇宙人レベルの論理で動いているから」です。

(※猫以外でも、例えば「サンドイッチの具が突然意識を持ったら……」なども面白そうです)結果が面白いかは微妙ですが⋯⋯

こちらの32Bのモデルは、私のPC環境で動かすにはギリギリかなというところです。

日常的に使うには、もう少し下げないと厳しいかもしれません。