中国企業が開発した生成AIモデル「DeepSeek-R1」が話題となっており、アプリストアでもランキングを伸ばしていますが、プライバシー保護の観点から利用することは待ったほうが良いです。この記事では、Windows PCのローカル環境で、安全にDeepSeek-R1を実行する方法をご紹介します。

Ollama Windows版とDeepSeek-R1とは

DeepSeek-R1の概要と、なぜローカルで実行すべきかについて解説します。

DeepSeek-R1とは

「DeepSeek-R1」とは、中国のDeepSeek社が開発したAIモデル(大規模言語モデル、LLM)です。

OpenAI社のo1モデルに匹敵する能力があるとされながらも、オープンソースのMITライセンスで無料公開されたことで、AI業界に激震が走っています。

無料で利用できる?

DeepSeek-R1は、Webチャットやアプリであれば無料で利用できます。

APIは従量課金です。

ただし個人情報漏えいの危険性があるため、現時点では推奨されません。

この記事では、Distillモデルをローカル環境で実行する方法をご紹介しています。

Distillモデルとは

Distill(蒸留)モデルとは、大規模なAIモデルを、バランスを取りながら小さなサイズに圧縮したものです。

フルサイズのモデルを実行するには高スペックが必要となりますが、Distillモデルであれば一般的なPCでも十分に実行可能です。

DeepSeek-R1では、「Qwen(アリババが開発したモデル)」や「LLaMA(メタが開発したモデル)」をベースとして、以下の6つのDistillモデルが公開されています。

| モデル | サイズ |

|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | 1.1GB |

| DeepSeek-R1-Distill-Qwen-7B | 4.7GB |

| DeepSeek-R1-Distill-Llama-8B | 4.9GB |

| DeepSeek-R1-Distill-Qwen-14B | 9GB |

| DeepSeek-R1-Distill-Qwen-32B | 20GB |

| DeepSeek-R1-Distill-Llama-70B | 43GB |

DeepSeekの危険性

DeepSeekに限らず生成AIには下記のような危険性がありますが、中国企業ということで、より一層の注意が必要となります。

個人情報・機密情報の漏洩

DeepSeekに入力した質問文、アップロードしたファイルなどは、全て中国に送信されます。

それ以外にも、ネットワーク情報、デバイス情報、キーストロークパターンなどが収集されることが、プライバシーポリシーに明記されています。

個人利用ならまだしも、仕事には絶対に使用するべきではないでしょう。

検閲・思想誘導

DeepSeekでは、中国政府の意に反するような質問はできないことが確認されています。

また、特定の質問に対する回答を意図的に調整することで、世論を誘導することが可能となります。(他のAIモデルでも同様です)

さらに、特定の質問をしたユーザーリストが中国政府に渡る懸念もあります。

Ollamaとは

「Ollama」とは、ローカル環境で大規模言語モデル(LLM、生成AI用データ)を実行できるツールです。

オープンソースで開発されており、無料で利用できます。

Windows、macOS、Linuxで実行できます。

Windowsの場合、Ollamaをインストールするだけであれば、Windows 10以降で、空き容量が4GB以上が必要です。

その他のシステム要件は、利用するモデルによって変わってきます。

OllamaでDeepSeek-R1を実行すれば、データが外部に送信されることはなく、安全に利用できます。

Ollama Windows版のインストールと使い方

Windowsのローカル環境にOllamaをインストールし、DeepSeek-R1を動かす方法をご紹介します。また、実際に質問をしてみた例もご紹介します。

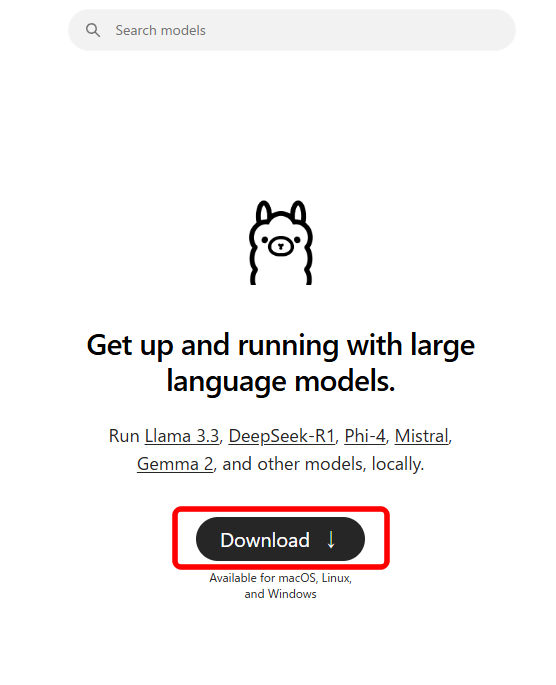

Ollama本体のインストール

OllamaをWindowsにインストールする方法は簡単です。

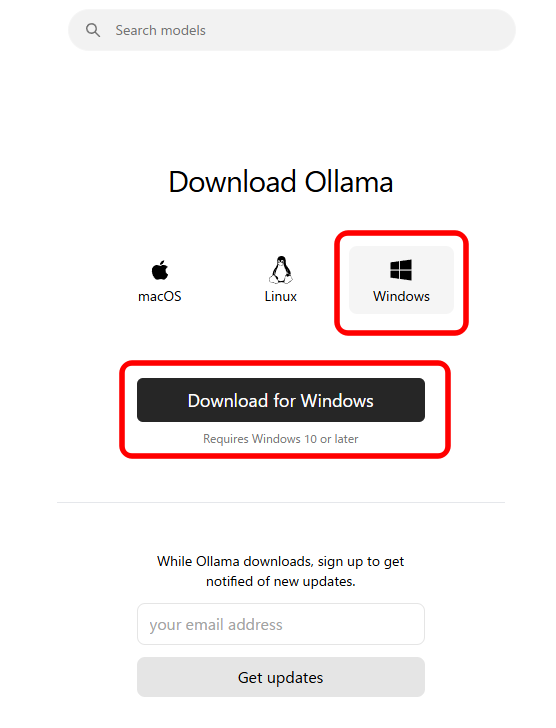

ブラウザで「https://ollama.com/」を開き、「Download」をクリックします。

「Windows」を選択し、「Download for Windows」をクリックします。

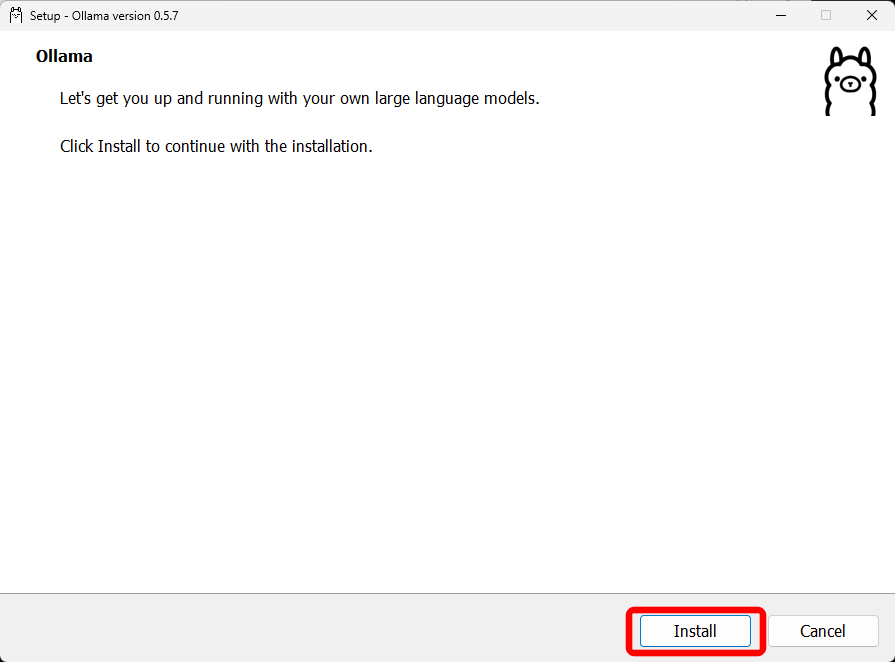

ダウンロードしたファイルを実行し、「Install」をクリックすれば完了です。

DeepSeek-R1のダウンロード

Ollama本体がインストールできたら、次はOllama上にモデルをダウンロードします。

利用できるモデルは、Ollamaのサイトで確認できます。

今回は「DeepSeek-R1-Distill-Qwen-32B(20GB)」を利用することにします。(動作が重い場合は、もう少し下げたほうがいいかもしれません)

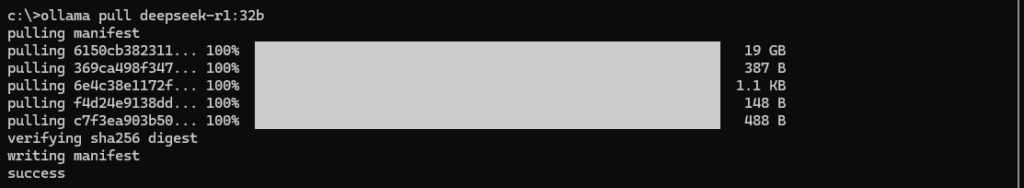

コマンドプロンプトを起動し、以下のコマンドを入力します。

ollama pull deepseek-r1:32b私のネットワーク環境では、20分ほどで完了しました。

Ollamaのコマンド

Ollamaでよく使うコマンドをご紹介します。

モデルの確認

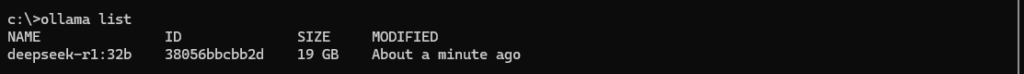

ダウンロードしたモデルを確認するには「list」コマンドを使います。

ollama list「NAME」がモデル名です。

「ID」はOllama上でモデルを識別するためのもので、モデル固有ではなく、ダウンロードする度に変わるようです。

モデルの実行

実行するには「run」コマンドで、モデル名を指定します。

ollama run deepseek-r1:32b起動するまで、少し時間がかかります。

プロンプトが表示されたら、質問文を入力します。

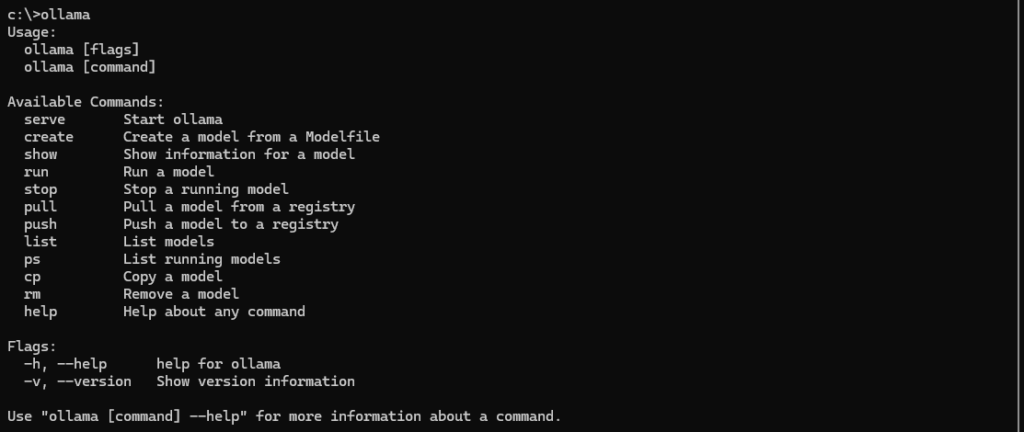

その他

コマンドプロンプトで単に「ollama」と入力すれば、その他の利用できるコマンドが確認できます。

ollamaOllamaでモデルを実行した後に「/?」と入力すれば、Ollama上で利用できるコマンドが確認できます。

DeepSeek-R1に質問してみる

Ollama上の「DeepSeek-R1-Distill-Qwen-32B」と、Web上の「DeepSeek-R1」に同じ質問をして、結果がどのように異なるのかをご紹介します。

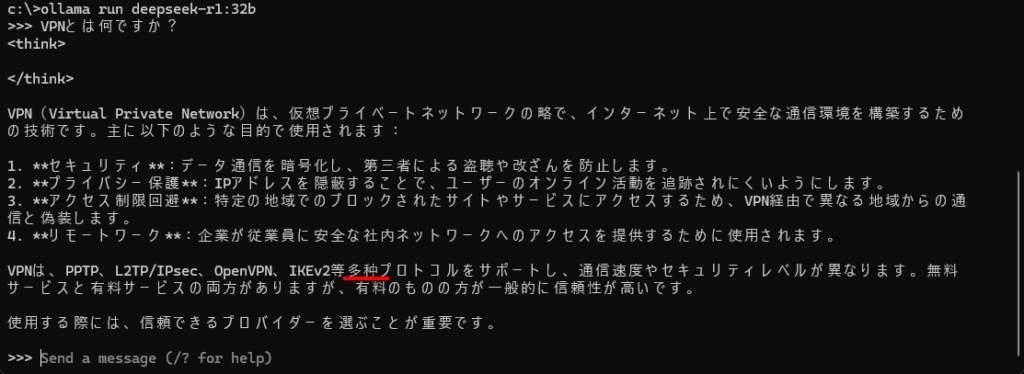

VPNとは何ですか?

まず、「VPNとは何ですか?」と聞いてみました。

Ollama

当たり障りのない、概要が回答されました。

<think>の間に、モデルの思考過程が表示されるようなのですが、空欄となっています。

一部、中国語が混じっています。

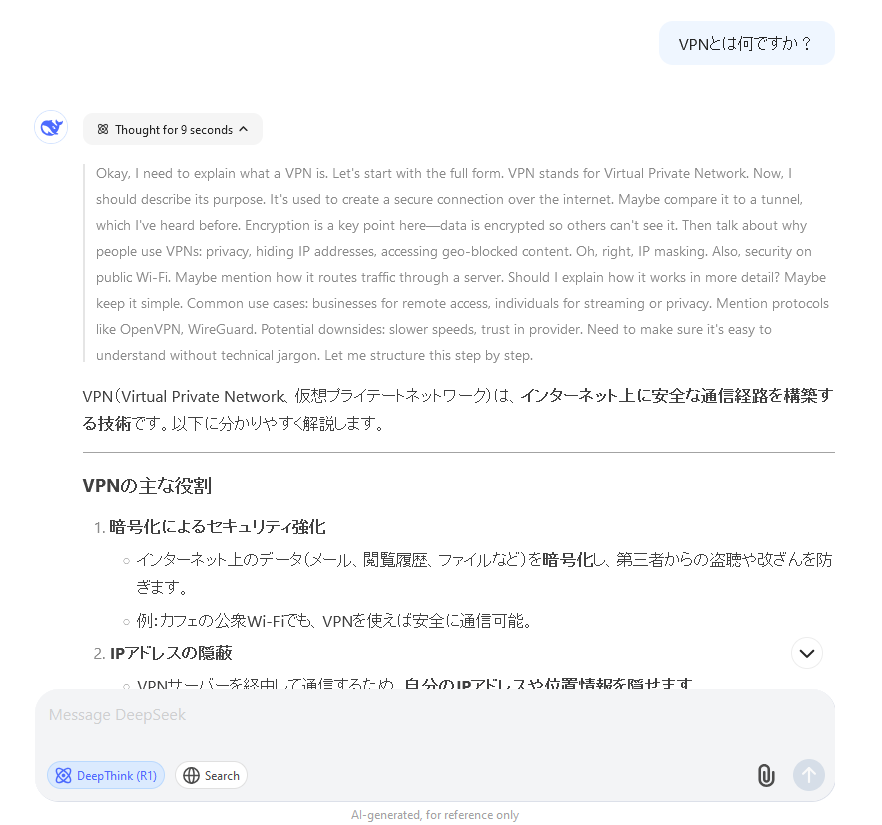

Web

Webの方では、回答の傾向は似ていますが、より詳細な内容となりました。

下記の画像では切れていますが、文章量にして4倍程度です。

また<think>の思考過程も表示されています。

中国語が混じることもなく、自然な日本語となっています。

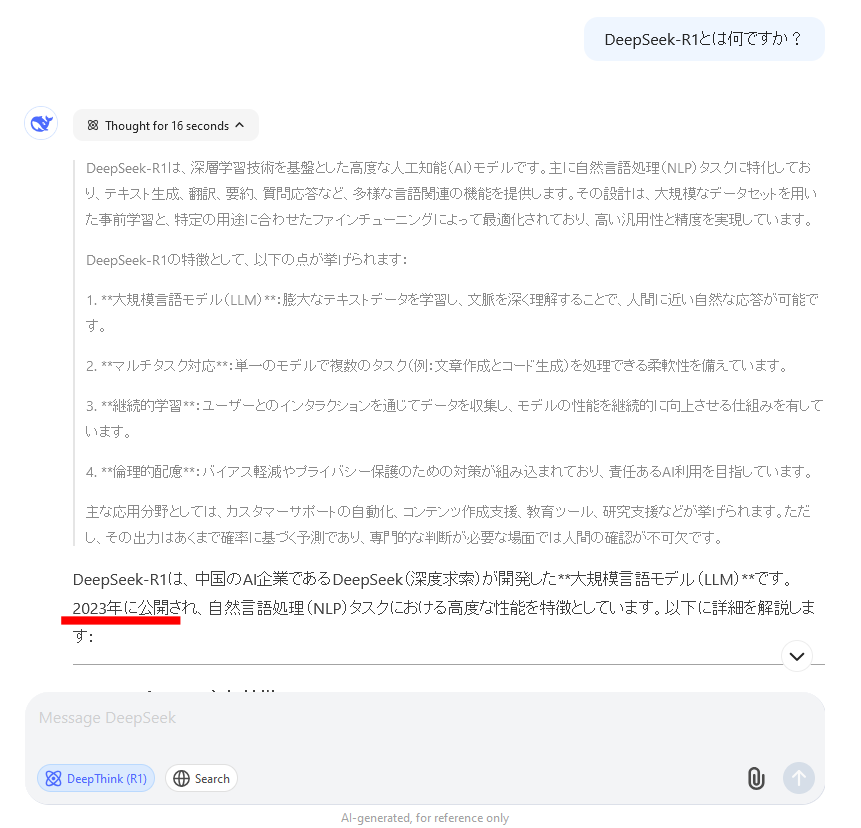

DeepSeek-R1とは何ですか?

今度は、DeepSeek-R1に「DeepSeek-R1とは何ですか?」と聞いてみました。

Ollama

何と、分からないという結果となりました。

それは単純に知識データが入っていないということでしょうが、注目すべきは、分からないなりにも推論をしているというところです。

Web

Webの方では正確な回答が⋯⋯

いや、ちょっと待ってください。

DeepSeek-R1が公開されたのは、2025年1月です。

2023年というのは、DeepSeek社が創業された年だと思われます。

つまりこれは誤った回答です。

ブラウザで使いたい

コマンドプロンプトではなく、ローカル環境でもブラウザから操作したい場合は、下記の記事をご参照ください。

スマホからもアクセスできるようになります。

-

OpenWebUIをWindowsにワンクリックでインストールする方法

AIをローカル環境で利用するニーズが高まっていますが、ブラウザから操作できる環境を作るのは、一般ユーザーには少しハードルが高いです。しかし、最近公開されたOpen WebUIのインストーラーを使えば、 ...